GPT-5/gpt-ossで追記した。

昔、サンタバーバラーという片田舎、ハリウッドになる前の映画の街にある会社に勤めていたことがある。そこの製品は、クラウドダッシュボードを提供していて、異なる操作、APIのクラウドを1つのダッシュボード、APIで使うことができるソリューションだった。追加機能で、ローカルのクラウド、それもパソコンで動くクラウド環境も連結できた。

何が便利かというと、パブリッククラウドでやるとコストが気になるオートスケール検証が、手元の環境、それも無料でできた。手元で開発して、必要なときにだけクラウド上で動かすことができた。これでクラウドの利用量がかなり安くなった。社員だったので、ダッシュボードの利用量も無料というのもあるが。とあるイベントで、ブースデモでオートスケールを見せたら、うちのブースだけ通路を塞ぐくらいの黒山の人だかりができてしまい、主催者から怒られた。そのソリューション、APIの提供だけではなく、メトリックスなどのオートスケールに必要な機能が付いていて便利だった。

閑話休題

クラウドのAIのAPIとローカルで動くLLM のAPIの使い方、セットアップ編。以下、Open AI APIとLM Studioの両方の利用法を書いてある。全くの別物なので、使う方だけ読むことにしても構わない。Open AI APIは、無料トライアルで済まそうとするなら、使う時に設定しておいたほうがいいと思う。

Open AI API

いわば、Chat GPTのAPIバージョン。有償のChat GPT Plusとは別の課金体型。ちょうどDeep L ProとAPIの関係に似ている。つまり、有償プランの契約者でもAPIは有償プランに含まれておらず、別に利用料を支払う必要がある。

料金体型

無料トライアルの内容

- 無料枠:2,500トークン

- 有効期限:3ヶ月

- 料金:トライアル期間終了後、または無料枠を使い切った後は、トークン数に応じた料金が発生します。

無料枠の確認方法

- OpenAIのダッシュボードで、Usageセクションにアクセスすると、API利用状況と料金を確認できます。

- 無料枠の利用状況も、この画面で確認できます。

無料枠を使い切った場合や、有効期限が切れた場合

- APIの利用を継続するには、料金を支払う必要があります。

- 料金は 使用したトークン数(入力・出力別)で計算されます。(入力トークンは「プロンプト(質問文など)」、出力トークンは「モデルの回答」を指します。)

- GPT-5の場合、1,000入力トークンあたり約0.0050ドル、1,000出力トークンあたり約0.0150ドルです。

- GPT-5-miniの場合、1,000入力トークンあたり約0.00025ドル、1,000出力トークンあたり約0.002ドルです。

API 価格表

https://platform.openai.com/docs/pricing

実際に選択できるのは

| モデル名 | 入力単価(USD/1K TOKENS) | 出力単価(USD/1K TOKENS) | 合計単価(USD/1K TOKENS) |

|---|---|---|---|

| gpt-5-nano | 0.00005 | 0.00040 | 0.00045 |

| gpt-4.1-nano | 0.00010 | 0.00040 | 0.00050 |

| gpt-4o-mini | 0.00015 | 0.00060 | 0.00075 |

| gpt-5-mini | 0.00025 | 0.00200 | 0.00225 |

| gpt-4.1-mini | 0.00040 | 0.00160 | 0.00200 |

| o4-mini | 0.00110 | 0.00440 | 0.00550 |

| o3-mini | 0.00110 | 0.00440 | 0.00550 |

| o1-mini | 0.00110 | 0.00440 | 0.00550 |

| gpt-5 | 0.00125 | 0.01000 | 0.01125 |

| gpt-4.1 | 0.00200 | 0.00800 | 0.01000 |

| o3 | 0.00200 | 0.00800 | 0.01000 |

| gpt-4o | 0.00250 | 0.01000 | 0.01250 |

テストで使うなら、gpt-5-nano、 本番利用なら、gpt-5か。ただし、gpt-5-nanoとgpt-5では値段が25倍も違う。入力と出力(トークン)に値段設定がついている。まぁ、テストでgpt-5-nanoなら、15回の利用で1円程度。月$5でもかなり大量に発行できる。なので、逆にループ処理など大量に発行するプログラムの作成をミスると、クラウド破産ならぬ、API破産が起こりうるんだが。(もちろん制限をかけられるのでそんなことはないと思う。)

自分は、Open AI APIが出てすぐにアカウントを作って使っていたため(すっかり忘れていた)、無料の期限なんてとっくに終わってて、いきなり有料からスタートになってしまった。(よく考えたらGmailも出たてのころUSでしかアカウントが作れなかったが、ちょうどNYに長期出張中でリリース1週間くらいでアカウントを作った記憶がある。ようは早いもの好きでつまみ食い。)

Open AI APIのアカウントを作ったら以下の設定をする。

お支払い

Chat GPT Plusとは別会計。クレカが必要。サブスクなので、毎月ドル払い。デフォルト$10だが最低価格の$5にした。

https://platform.openai.com/settings/organization/billing/overview

Limit

月$しか設定していないが、とりあえず$10にした。テストレベルでモデルをちゃんと選べばここまで使うのも難しいと思う。

https://platform.openai.com/settings/organization/limits

利用量、課金表示

どれくらい使ったが見える。

https://platform.openai.com/settings/organization/usage

APIキー

以下でAPIキーを生成しておく。

https://platform.openai.com/settings/organization/api-keys

これでOpen AI APIを使う準備は完了

あとは、APIでAPIキーとモデルを呼び出して使えばいい。

こんな危ない橋を渡りたくない人は、次に説明するLM Studioを使うことをおすすめする。モデルのロード時以外は、モデルのダウンロード以外ではインターネットを使わない、商用利用が認められている無料ソフトウェアなので。

以下、すごく簡単なサンプル。適当なパソコンで以下を実行する。インターネットが繋がっていれば、MacあるいはLinuxで実行する。WindowsだとPowerShellになるので、ヒアドキュメントにして、curlではなく、curl.exeを使う必要がある。(WindowsならWSLのLinuxから実行したほうが無難)

OPENAI_API_KEYに自分のAPIキーを入れる。モデルは一般的なパラメータが使える一番小さいモデルを指定している。(gpt-5-nanoだと少しパラメータを変える必要がある。)

export OPENAI_API_KEY="XXXXXXXXXXXXXXX”

curl -s https://api.openai.com/v1/chat/completions \

-H "Content-Type: application/json” \

-H "Authorization: Bearer $OPENAI_API_KEY” \

-d ‘{

"model": "gpt-4.1-nano”,

"temperature": 0.7,

"max_tokens": 500,

"top_p": 0.9,

"presence_penalty": 0.0,

"frequency_penalty": 0.0,

"messages": [

{"role": "system", "content": "ou are a helpful assistant. Always answer in Japanese and provide factual accuracy.”},

{"role": "user", "content": "現在の日本の内閣総理大臣は?”}

]

}'

gpt-4o-mini, gpt-5-nano の場合は、max_tokensではなく、max_completion_tokensを使う。

curl -s https://api.openai.com/v1/chat/completions \

-H "Content-Type: application/json” \

-H "Authorization: Bearer $OPENAI_API_KEY” \

-d ‘{

"model": "gpt-5-nano”,

"max_completion_tokens": 500,

"messages": [

{"role": "system", "content": "ou are a helpful assistant. Always answer in Japanese and provide factual accuracy.”},

{"role": "user", "content": "現在の日本の内閣総理大臣は?”}

]

}'

LM Studio

これは、Chat GPTのような事前学習型のAIをローカルで使えるようにするアプリケーション。いわゆるローカルLLM。Mac (Apple Silicon) / Windows / Linux版がある。Windows版は、なんとなく日本語の扱いがおかしいような気がするので、MACかLinuxがおすすめ。

動作要件

https://lmstudio.ai/docs/app/system-requirements

MACならM1以上であれば問題ない。それに一番無難。さらに一番コスパがいい。Windows/LinuxでIntel CPUだとAVX2 インストラクションをサポートしているIntel CPUで16GB RAMが必要。メモリはあればあるほどいい。

これは、何を意味するかというと、Intel 第4世代以降で16GB RAM以上ということなんだが、第4世代 16GB RAMって当時のMAX構成。ただし、Intel CPUの場合、CPUにGPUがあっても使ってくれるケースがほとんどない。あっても12世代以上で限定的、たいていはCPUのパフォーマンスしか出ない。

そこそこサクサク使いたいのであれば、Mac Miniを買いに行ったほうがいいかも。AmazonでM4 Mac Mini 16GBが約9万円。ただし、LM Studioを使う最低要件が16GBなので、動かせるモデルに制限がでるかもしれない。それでもWindowsにGPUを付けるよりは安い。ちなみにM4 Mac Miniで32GB RAMだと18万円。ど新規で買うならありだが、Windowsパソコンに増設するとなると微妙なレベルかもしれない。GPUガンガンに回して使う大規模用途だと、WindowsもMACもあまり費用は変わらない。まぁ、M4 Mac Mini 16GBでも最初は十分遊べる。(大蔵大臣におねだりするなら。)

インストール

以下からダウンロードしてインストール (無償。かかるのはもはや電気代のみ)

MACならApplicationへコピー、Windowsなら単純にセットアップ。パラメータはない。

起動

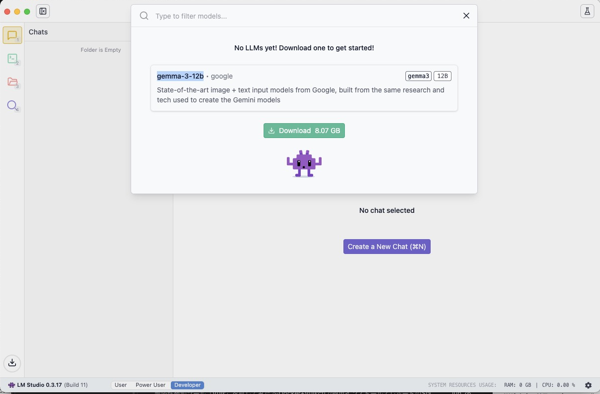

立ち上げると、Chat GPTみたいなUIが出てくる。モデルをロードしないと使えない。以下は、最初のサンプル。他にも選べる。選ぶには左側の虫眼鏡メニューをクリック。

モデルは、Open AI APIでも出てきたものと同じで様々なモデルがネットを騒がせている。どのモデルが最適かは、CPU型番と特に搭載メモリ量に依存をする。

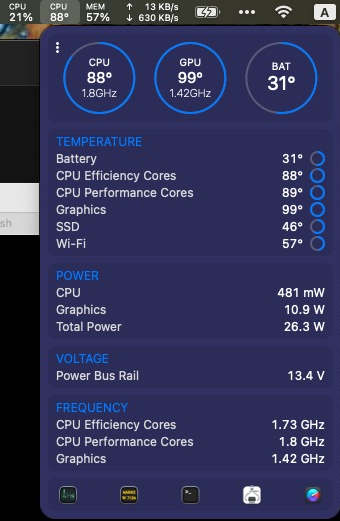

このモデルGemma-3-12bは、Apple SiliconだとMetalを使ってくれる。GPUの利用率メータが100%になる。ただし、32GB以上必要なので、M4 Mac Miniならば、Gemma-2B(Q4_K_M)くらいがいい。Intel CPUならば、Intel第12世代Corei7 32GB RAMは必要。

最近リリースされた、gpt-oss-20bも利用ができる。

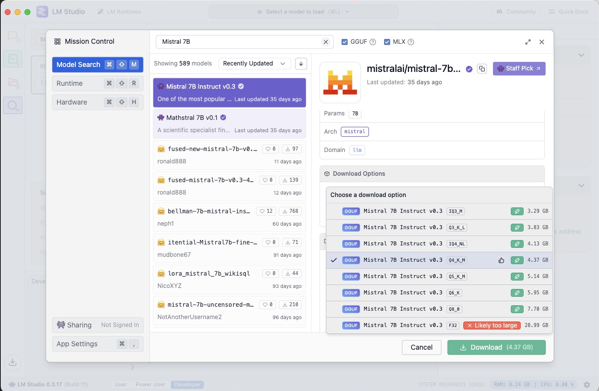

モデルの選択に関してはChat GPTなどに聞いたほうがいいかもしれない。ただし、モデルの種類にパラメータがあるので、モデルを最初に選んで、パラメーターを指定してダウンロードをする。モデルを選んだら右のペインでパラメーターを選択する。また、動かないのは、動かないじゃない?というサジェスチョンがでる親切設計。

また、全てのモデルがMCPなどのフォーマットに対応をしているわけではない。

これこそAIに聞くべき。

プロンプト

LM Studioを使う。<CPU> で搭載メモリがXXGBのMAC環境で、MCP準拠、Open API API互換でおすすめのモデルとパラメーターは?

例 LM Studioを使う。M4 Apple Siliconで搭載メモリが32GBのMAC環境で、MCP準拠、Open API API互換でおすすめのモデルとパラメーターは?

Nous Hermes 2 Mistral 7B – Q4_K_M

であると教えてくれた。Mistral 7Bを検索して、Q4_K_Mをダウンロード。

AIに聞くと、どちらかというとCPUよりメモリ容量のほうが重要な様子。(なので、Mac Miniを買う時は、メモリを追加したほうがいいかも)

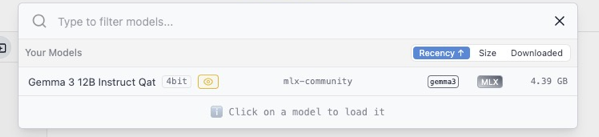

モデルのダウンロードはGBクラスのファイルなので、ダウンロードを待つ。ダウンロードを完了したら、

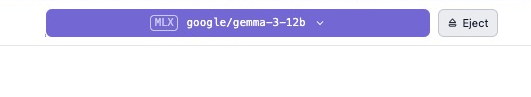

モデルをロードする。ロードが完了すると、

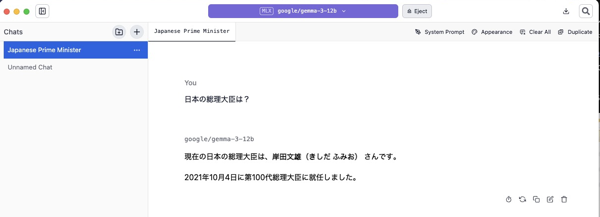

お約束の質問をしてみる。

はい。岸田さんまでしか知らないモデルがダウンロードされましたw。ちょうど100代目の総理大臣だったんですね。記念式典とかしてあげればよかったかなぁ。

ちなみに、別のモデルをロードして同じ質問をしてみたところ。。。

前任の方は、阿部さんという方だったらしい。なんか近所のおじさんみたいな名前の人だなぁ。。。安倍さんのほうが品がありますね。

↑は間違い。前任は菅さんだった。。。忘れてられている。

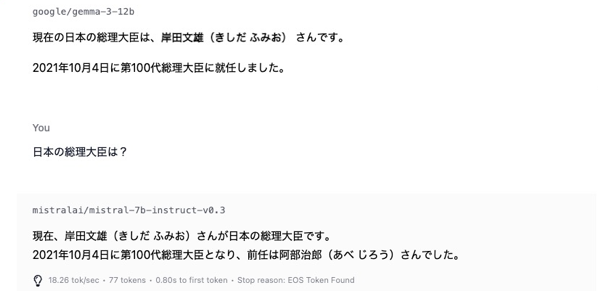

context-sizeの長さの確認

context-sizeの長さを確認をしておくことを薦める。これより長いcontext-sizeは受け付けない。LM Studioの場合、長すぎるcontext-sizeを受け取るとしれっと何もしない。(context-sizeが長すぎてだめなのか、他のエラーなのかわからない。)以下のLoadタブで確認、変更ができる。

ただし、長くするにはメモリが必要。デフォルトが4096のものが多いような気がする。gpt-4.1-nanoと同じ長さなので特に変える必要はないかもしれない。長いcontext-sizeを使うには、Open AI APIの場合はお金、LM Studioの場合はメモリが必要と持っておけば問題はないような。どっちも最終的にはお金だが。

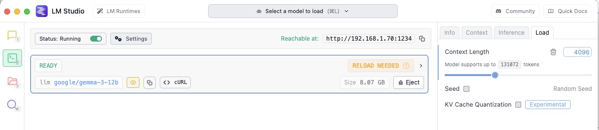

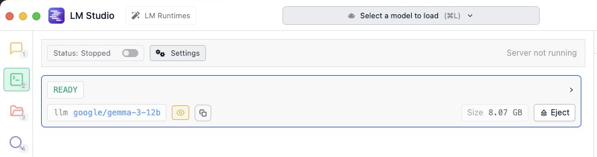

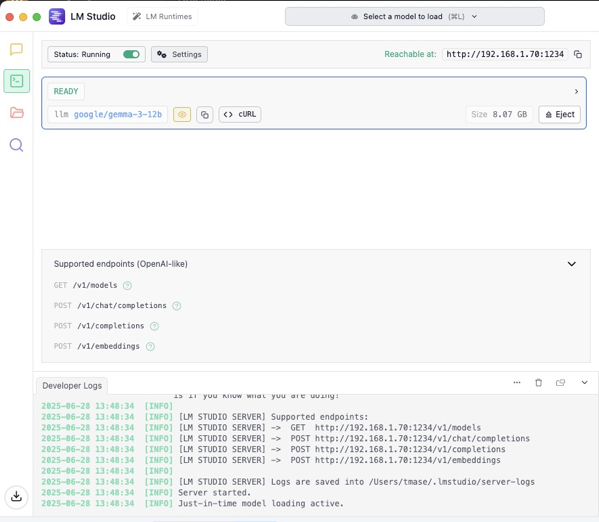

API サーバの設定

さて、APIを使うには、APIサーバを有効にする必要がある。

画面下側の設定をDeveloperに変える。

![]()

左のメニューで上から2番目のAPIの画面をクリックするとStatusがStoppedとなっている。

Runningに変える。Developer LogsにAPIのログが出てくる。これ、地味に重要。API実行時に役に立つ。

これでローカルホストからAPIを使うことができる。

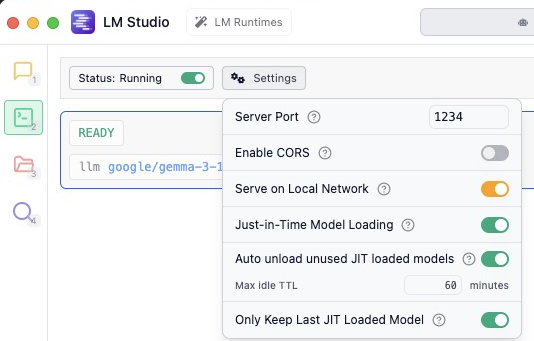

他のマシンからも使えるようにするためには、

Settingsをクリックして、Serve on Local Networkをオンにすると他のホストからも使える。

自分の場合、手元のMACにアプリを今の所入れたくないが、テスト用のUbuntuをデプロイしてネットワークから使っている。さらに、Roon Serverで使っているWIndow 11にもLM Studioをインストール、ネットワーク経由の利用を有効にして、Intel CPUのクソ遅さを体感するために切り替えて使っている。

試しに、http://localhost:1234/v1/models あるいはhttp://<LM Studioが動いているサーバ>:1234/v1/models をAPIで叩いてみる。

{

"data": [

{

"id": "google/gemma-3-12b”,

"object": “model”,

"owned_by": “organization_owner”

},

{

"id": "text-embedding-nomic-embed-text-v1.5”,

"object": “model”,

"owned_by": “organization_owner”

},

{

"id": "openai/gpt-oss-20b”,

"object": “model”,

"owned_by": “organization_owner”

}

],

"object": “list”

}

と出てくる。

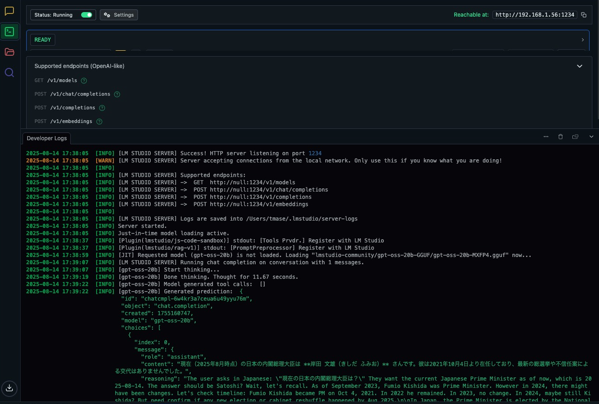

以下、すごく簡単なサンプル。別マシンのLM Studioに接続したい場合は、localhostの部分を別IPアドレスにする。Open AI APIと違い、認証がない、モデル名が違う以外は同じ。LM Studioに接続できれば、環境は問わない。またモデルはロードしなくても勝手にロードしてくれる。対話モードでモデルをロードしている場合は、Ejectしておいたほうがいいかも。(たまにリソース不足でAPIが反応しなくなることがあったので)

curl -s http://localhost:1234/v1/chat/completions \

-H "Content-Type: application/json” \

-d ‘{

"model": "gpt-oss-20b”,

"temperature": 0.7,

"max_tokens": 500,

"top_p": 0.9,

"presence_penalty": 0.0,

"frequency_penalty": 0.0,

"messages": [

{"role": "system", "content": "You are a helpful assistant. Always answer in Japanese and provide factual accuracy.”},

{"role": "user", "content": "現在の日本の内閣総理大臣は?”}

]

}'

実際に動かすとこんな感じでGPUが動き始める。このテストだと、こんなにいかずに終わるが。

うまく動作しない場合は、

- APIを有効にしているか

- Local Networkを有効にしているか

などを確認をする。また、LM Studioのログでも確認できる。

さて、今回はここまで、次回は実際にOpen AI API / LM Studioで使ってみる。(もうブログ自体は書けている。)

完全に以下余談。

次回は、jsonが出てくる。ジェイソンといえば、13日の金曜日だが、兄の誕生日は6月13日。今年の誕生日は、金曜日だった。試しに6月13日が金曜日になるのは人生で何回あるのか調べてみた。

以下が「ジェソンバースデー」(もちろんAIに聞いてみた。)

1980年 6歳

1986年 12歳

1997年 23歳

2003年 29歳

2008年 34歳

2014年 40歳

2025年 51歳

2031年 57歳

2042年 68歳

2048年 74歳

2053年 79歳

2059年 85歳

2064年 90歳

2070年 96歳

2075年 101歳

2081年 107歳

2087年 113歳

2092年 118歳

たいてい5、6年に一度に遭遇するのだが、40歳から51歳で11年間空いている。今年は久々のジェイソンバースデーだった盛大にお祝いしてあげるべきだったか。ちなみに57歳から68歳も11年間空いているなぁ。